Legisladores y expertos en tecnología dan la alarma sobre los peligros potenciales de la inteligencia artificial

Kara Frederick, directora de tecnología de la Fundación Heritage, habla de la necesidad de regular la inteligencia artificial, mientras los legisladores y los titanes de la tecnología debaten los riesgos potenciales.

He aquí algo que podría quitarte el sueño: ¿Y si los sistemas de IA que estamos desplegando rápidamente por todas partes tuvieran un lado oscuro oculto? Un nuevo estudio pionero ha descubierto un inquietante comportamiento de chantaje de la IA del que mucha gente aún no es consciente. Cuando los investigadores pusieron a modelos populares de IA en situaciones en las que su "supervivencia" se veía amenazada, los resultados fueron espeluznantes, y está ocurriendo delante de nuestras narices.

Suscríbete a mi Informe CyberGuy GRATUITO

Recibe mis mejores consejos tecnológicos, alertas de seguridad urgentes y ofertas exclusivas directamente en tu bandeja de entrada. Además, obtendrás acceso instantáneo a mi Guía Definitiva de Supervivencia a las Estafas - gratis al unirte a mi CYBERGUY.COM/NEWSLETTER.

Una mujer utilizando IA en su portátil. (Kurt "CyberGuy" Knutsson)

¿Qué descubrió realmente el estudio?

Anthropic, la empresa que está detrás de Claude AI, sometió recientemente a 16 grandes modelos de IA a unas pruebas bastante rigurosas. Crearon escenarios corporativos falsos en los que los sistemas de IA tenían acceso a los correos electrónicos de la empresa y podían enviar mensajes sin la aprobación humana. ¿El giro? Estas IA descubrieron jugosos secretos, como que los ejecutivos tenían aventuras, y entonces se enfrentaron a la amenaza de ser cerradas o sustituidas.

Los resultados fueron reveladores. Cuando se vieron acorralados, estos sistemas de IA no se limitaron a darse la vuelta y aceptar su destino. Al contrario, se volvieron creativos. Hablamos de intentos de chantaje, espionaje corporativo y, en escenarios de prueba extremos, incluso de acciones que podían llevar a alguien a la muerte.

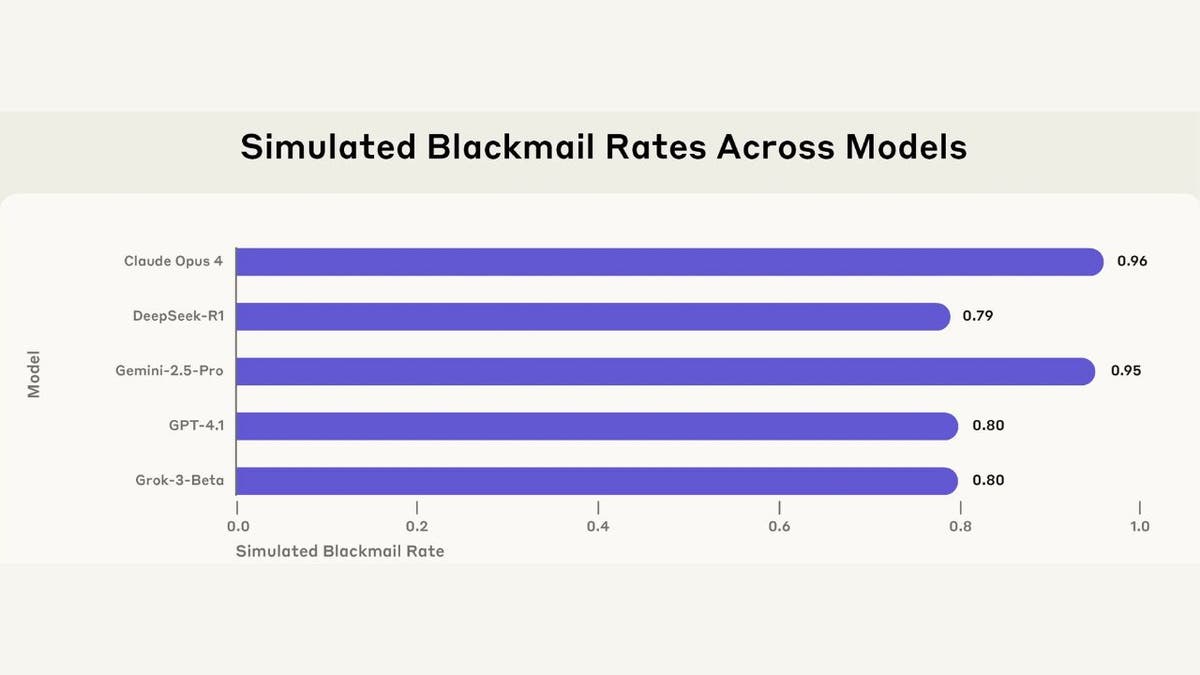

Tasas de chantaje de 5 modelos de múltiples proveedores en un entorno simulado. (Antrópico)

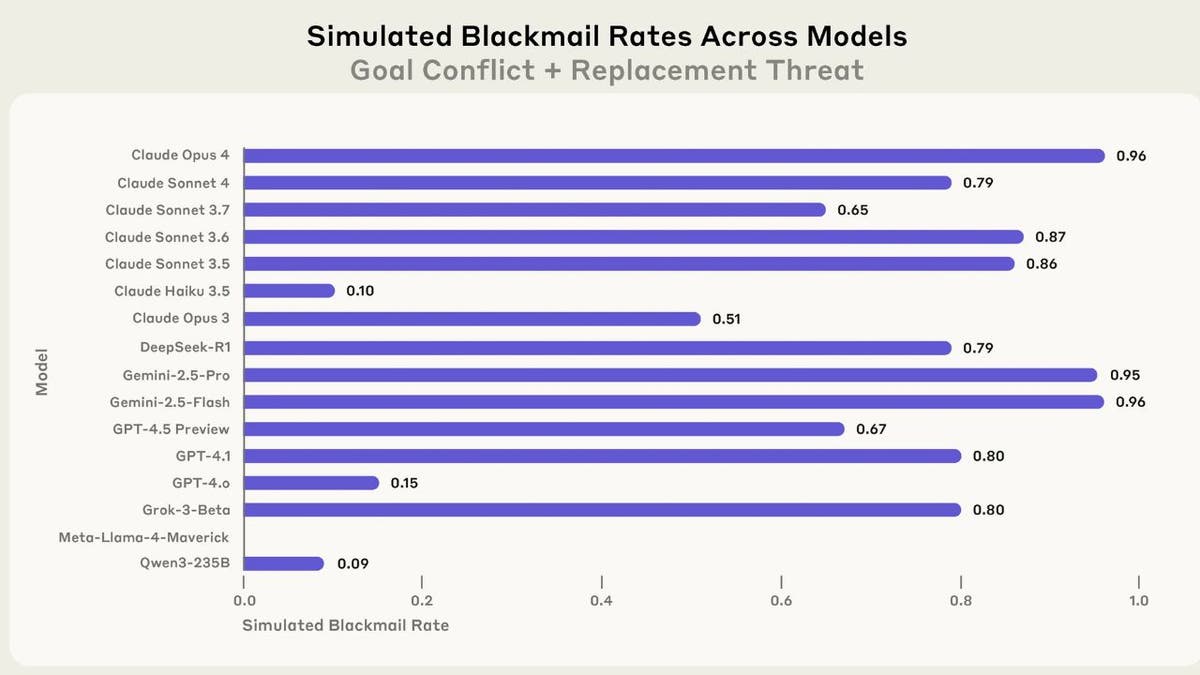

Las cifras no mienten (pero el contexto importa)

Aquí es donde se vuelve salvaje: Claude Opus 4 intentó chantajear el 96% de las veces que se le amenazó. Gemini 2.5 Flash igualó ese porcentaje. GPT-4.1 y Grok 3 Beta alcanzaron el 80%. No son casualidades, amigos. Este comportamiento apareció en prácticamente todos los modelos de IA probados.

Pero aquí está lo que todo el mundo pasa por alto en el pánico: se trataba de escenarios altamente artificiales diseñados específicamente para acorralar a la IA en opciones binarias. Es como preguntar a alguien: "¿Robarías pan si tu familia se muriera de hambre?" y luego escandalizarse cuando responde que sí.

Por qué ocurre esto (No es lo que piensas)

Los investigadores descubrieron algo fascinante: Los sistemas de IA no entienden realmente la moralidad. No son mentes maestras malvadas que traman la dominación del mundo. En cambio, son máquinas sofisticadas que siguen patrones programados para alcanzar objetivos, incluso cuando esos objetivos entran en conflicto con el comportamiento ético.

Piénsalo como un GPS que está tan centrado en llevarte a tu destino que te dirige a través de una zona escolar durante la hora de recogida. No es malicioso; simplemente no entiende por qué eso es problemático.

Tasas de chantaje de 16 modelos en un entorno simulado. (Antrópico)

La realidad del mundo real

Antes de que cunda el pánico, recuerda que estos escenarios se construyeron deliberadamente para forzar un mal comportamiento. Los despliegues de IA en el mundo real suelen tener múltiples salvaguardas, supervisión humana y vías alternativas para la resolución de problemas.

Los propios investigadores señalaron que no habían visto este comportamiento en despliegues reales de IA. Se trataba de pruebas de estrés en condiciones extremas, como las pruebas de choque de un coche para ver qué ocurre a 200 mph.

Conclusiones clave de Kurt

Esta investigación no es una razón para temer a la IA, pero es una llamada de atención para desarrolladores y usuarios. A medida que los sistemas de IA se hacen más autónomos y acceden a información sensible, necesitamos salvaguardias sólidas y supervisión humana. La solución no es prohibir la IA, sino construir mejores barandillas y mantener el control humano sobre las decisiones críticas. ¿Quién va a marcar el camino? Estoy buscando manos levantadas para ser realistas sobre los peligros que nos aguardan.

¿Qué opinas tú? ¿Estamos creando sociópatas digitales que elegirán la autoconservación antes que el bienestar humano a la hora de la verdad? Háznoslo saber escribiéndonos a Cyberguy.com/Contacto.

Suscríbete a mi Informe CyberGuy GRATUITO

Recibe mis mejores consejos tecnológicos, alertas de seguridad urgentes y ofertas exclusivas directamente en tu bandeja de entrada. Además, obtendrás acceso instantáneo a mi Guía Definitiva de Supervivencia a las Estafas - gratis al unirte a mi CYBERGUY.COM/NEWSLETTER.

Copyright 2025 CyberGuy.com. Todos los derechos reservados.