House artificial intelligence task force chair talks goals, risks for AI

Rep. Jay Obernolte was selected to lead the House task force on AI. Fox News Digital speaks with the California Republican about his goals for the panel and his own thoughts about the rapidly advancing technology.

Researchers are warning that facial recognition technologies are "more threatening than previously thought" and pose "serious challenges to privacy" after a study found that artificial intelligence can be successful in predicting a person’s political orientation based on images of expressionless faces.

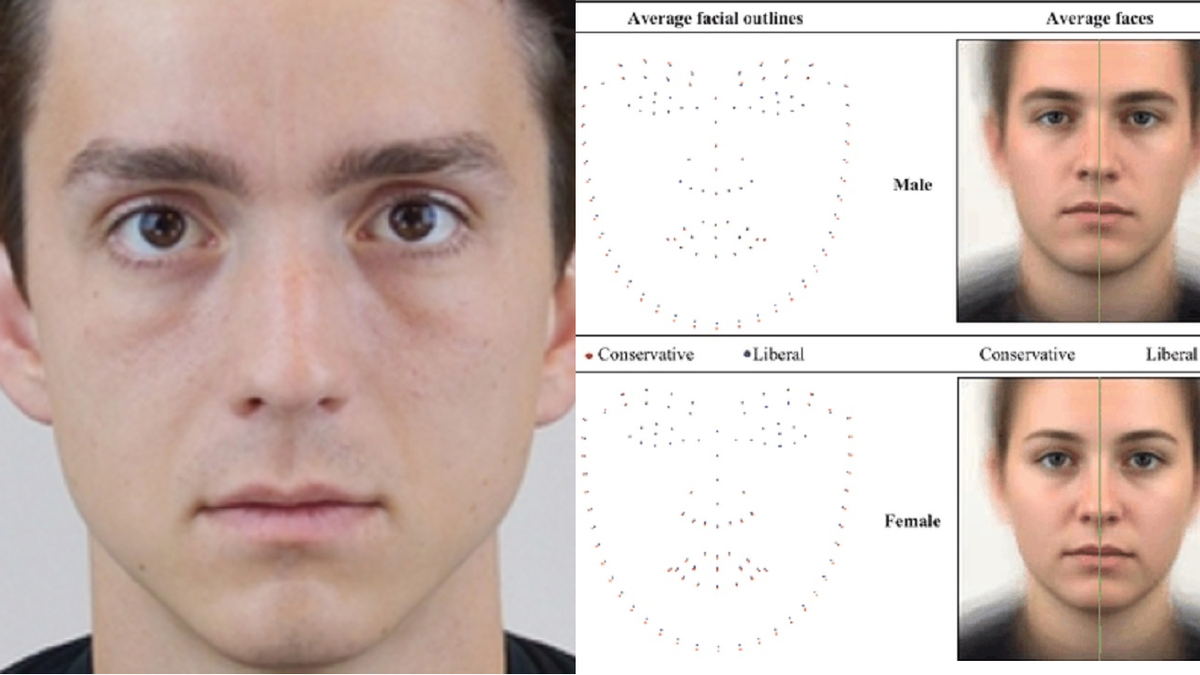

A recent study published in the journal American Psychologist says an algorithm’s ability to accurately guess one’s political views is "on par with how well job interviews predict job success, or alcohol drives aggressiveness." Lead author Michal Kosinski told Fox News Digital that 591 participants filled out a political orientation questionnaire before the AI captured what he described as a numerical "fingerprint" of their faces and compared them to a database of their responses to predict their views.

"I think that people don’t realize how much they expose by simply putting a picture out there," said Kosinski, an associate professor of organizational behavior at Stanford University’s Graduate School of Business.

"We know that people’s sexual orientation, political orientation, religious views should be protected. It used to be different. In the past, you could enter anybody’s Facebook account and see, for example, their political views, the likes, the pages they follow. But many years ago, Facebook closed this because it was clear for policymakers and Facebook and journalists that it is just not acceptable. It’s too dangerous," he continued.

GOOGLE CONSOLIDATES AI-FOCUSED DEEPMIND, RESEARCH TEAMS

The study used AI to predict people's political orientation based on images of expressionless faces.

"But you can still go to Facebook and see anybody’s picture. This person never met you, they never allowed you to look at a picture, they would never share their political orientation ... and yet, Facebook shows you their picture, and what our study shows is that this is essentially to some extent the equivalent to just telling you what their political orientation is," Kosinski added.

For the study, the authors said the images of the participants were collected in a highly controlled manner.

"Participants wore a black T-shirt adjusted using binder clips to cover their clothes. They removed all jewelry and – if necessary – shaved facial hair. Face wipes were used to remove cosmetics until no residues were detected on a fresh wipe. Their hair was pulled back using hair ties, hair pins, and a headband while taking care to avoid flyaway hairs," they wrote.

The facial recognition algorithm VGGFace2 then examined the images to determine "face descriptors, or a numerical vector that is both unique to that individual and consistent across their different images," it said.

AIR FORCE CONFIRMS FIRST SUCCESSFUL AI DOGFIGHT

AI can reportedly predict political orientations from blank faces. (Jakub Porzycki/NurPhoto via Getty Images/File)

"Descriptors extracted from a given image are compared to those stored in a database. If they are similar enough, the faces are considered a match. Here, we use a linear regression to map face descriptors on a political orientation scale and then use this mapping to predict political orientation for a previously unseen face," the study also said.

The authors wrote that their findings "underscore the urgency for scholars, the public, and policymakers to recognize and address the potential risks of facial recognition technology to personal privacy" and that an "analysis of facial features associated with political orientation revealed that conservatives tended to have larger lower faces."

"Perhaps most crucially, our findings suggest that widespread biometric surveillance technologies are more threatening than previously thought," the study warned. "Previous research showed that naturalistic facial images convey information about political orientation and other intimate traits. But it was unclear whether the predictions were enabled by self-presentation, stable facial features, or both. Our results, suggesting that stable facial features convey a substantial amount of the signal, imply that individuals have less control over their privacy."

Kosinski told Fox News Digital that "algorithms can be very easily applied to millions of people very quickly and cheaply" and that the study is "more of a warning tale" about the technology "that is in your phone and is very widely used everywhere."

AI can reportedly predict political orientations from blank faces. (Visions of America/Universal Images Group via Getty Images/File)

CLICK HERE TO GET THE FOX NEWS APP

The authors concluded that "even crude estimates of people’s character traits can significantly improve the efficiency of online mass persuasion campaigns" and that "scholars, the public, and policymakers should take notice and consider tightening policies regulating the recording and processing of facial images."