Un experto da la alarma sobre el impacto del tiempo frente a la pantalla en el comportamiento y la salud mental de los niños

La directora ejecutiva de Madres contra la Adicción a los Medios, Julie Scelfo, se une a "Fox & Friends First" para hablar del impacto del tiempo frente a la pantalla en la salud mental y el desarrollo de los niños, mientras los legisladores se disponen a examinar el impacto de las pantallas en el aprendizaje en las aulas.

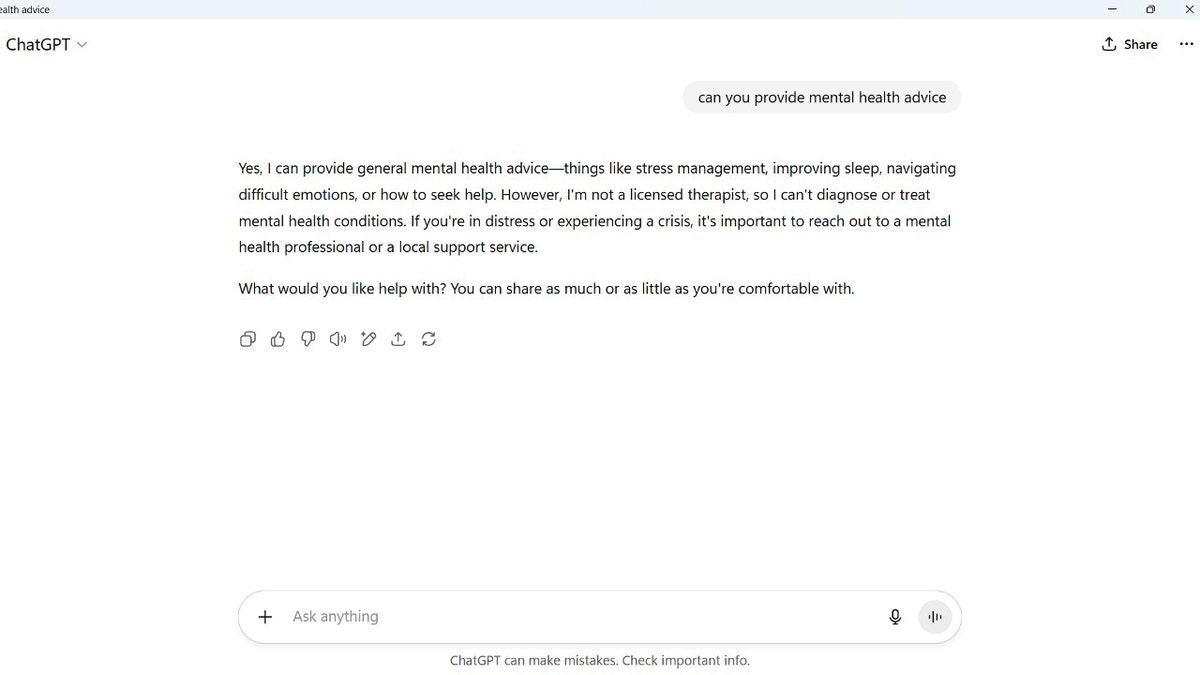

Cada vez más gente recurre a la inteligencia artificial en busca de ayuda, incluso para asesoramiento sobre salud mental. Es fácil ver por qué: herramientas como ChatGPT son gratuitas, rápidas y siempre están disponibles. Pero la salud mental es un tema delicado, y la IA no está preparada para manejar las complejidades de la angustia emocional real.

Para hacer frente a las crecientes preocupaciones, OpenAI ha introducido nuevas medidas de seguridad para ChatGPT. Estas actualizaciones limitarán la forma en que el chatbot responde a las consultas relacionadas con la salud mental. El objetivo es evitar que los usuarios se vuelvan excesivamente dependientes y animarles a buscar la atención adecuada. OpenAI también espera reducir con estos cambios el riesgo de respuestas perjudiciales o engañosas.

Suscríbete a mi Informe CyberGuy GRATUITO

Recibe mis mejores consejos tecnológicos, alertas de seguridad urgentes y ofertas exclusivas directamente en tu bandeja de entrada. Además, obtendrás acceso instantáneo a mi Guía Definitiva de Supervivencia a las Estafas - gratis al unirte a mi CYBERGUY.COM/NEWSLETTER

Una captura de pantalla muestra la interfaz de la ventana prompt ChatGPT . (Kurt "CyberGuy" Knutsson)

¿Por qué hace OpenAI este cambio?

En una declaración publicada por OpenAI, la empresa admitió que "ha habido casos en los que nuestro modelo 4o se quedó corto a la hora de reconocer signos de delirio o dependencia emocional". En un ejemplo, ChatGPT validó la creencia de un usuario de que las señales de radio atravesaban las paredes por culpa de su familia. En otro, supuestamente fomentaba el terrorismo.

Estos incidentes, raros pero graves, suscitaron preocupación. OpenAI está revisando ahora la forma en que entrena a sus modelos para reducir la "adulancia", o acuerdo y adulación excesivos que podrían reforzar creencias perjudiciales.

Captura de pantalla de un aviso que pregunta si ChatGPT puede proporcionar asesoramiento sobre salud mental (Kurt "CyberGuy" Knutsson)

¿Qué nuevas salvaguardias ha establecido OpenAI ?

A partir de ahora ChatGPT pedirá a los usuarios que hagan pausas durante las conversaciones largas. También evitará ofrecer consejos específicos sobre temas profundamente personales. En su lugar, el chatbot ayudará a los usuarios a reflexionar haciéndoles preguntas y ofreciéndoles pros y contras, sin pretender ser un terapeuta.

OpenAI declaró: "Aunque es poco frecuente, seguimos mejorando nuestros modelos y estamos desarrollando herramientas para detectar mejor los signos de angustia mental o emocional, de modo que ChatGPT pueda responder adecuadamente y dirigir a las personas a recursos basados en pruebas cuando sea necesario."

La empresa también se ha asociado con más de 90 médicos de todo el mundo para crear una guía actualizada para evaluar las interacciones complejas. Un grupo asesor, formado por expertos en salud mental, defensores de los jóvenes e investigadores de la interacción persona-ordenador, está ayudando a dar forma a estos cambios. OpenAI afirma que desea recibir aportaciones de médicos e investigadores para perfeccionar aún más sus salvaguardias.

Captura de pantalla de un usuario pidiendo ChatGPT que "Me anime con un chiste". (Kurt "CyberGuy" Knutsson)

Tus conversaciones privadas con ChatGPT no están protegidas legalmente

ElCEO OpenAI , Sam Altman, planteó recientemente una serie de cuestiones sobre la privacidad de la IA. "Si vas a hablar con ChatGPT sobre tus cosas más sensibles y luego hay una demanda o lo que sea, se nos podría exigir que presentáramos eso. Y creo que eso es muy jodido", dijo.

Y añadió: "Creo que deberíamos tener el mismo concepto de privacidad para tus conversaciones con la IA que el que tenemos con un terapeuta o lo que sea".

Así que, a diferencia de hablar con un consejero licenciado, tus charlas con ChatGPT no gozan de privilegio legal ni confidencialidad. Ten cuidado con lo que compartes.

LOS ESTAFADORES PUEDEN EXPLOTAR TUS DATOS A PARTIR DE 1 SOLA BÚSQUEDA EN CHATGPT

Qué significa esto para ti

Si recurres a ChatGPT para obtener apoyo emocional, comprende sus límites. El chatbot puede ayudarte a reflexionar sobre los problemas, hacer preguntas orientativas o simular una conversación, pero no puede sustituir a los profesionales de la salud mental formados.

Esto es lo que debes tener en cuenta:

- No confíes en ChatGPT en una crisis. Si tienes problemas, busca ayuda de un terapeuta titulado o llama a un teléfono de crisis.

- Asume que tus chats no son privados. Trata tus conversaciones de IA como si pudieran ser leídas por otros, especialmente en asuntos legales.

- Utilízalo para reflexionar, no para resolver. ChatGPT es mejor para ayudarte a ordenar tus pensamientos, no para resolver problemas emocionales profundos.

Los cambios de OpenAI son un paso adelante hacia interacciones más seguras, pero no son una panacea. La salud mental requiere conexión humana, formación y empatía, cosas que ninguna IA puede reproducir totalmente.

Responde a mi cuestionario: ¿Cómo de segura es tu seguridad en Internet?

¿Crees que tus dispositivos y datos están realmente protegidos? Haz este rápido cuestionario para ver en qué punto se encuentran tus hábitos digitales. Desde las contraseñas hasta la configuración Wi-Fi, obtendrás un desglose personalizado de lo que haces bien, y de lo que necesitas mejorar. Haz mi cuestionario aquí: Cyberguy.com/Cuestionario

Conclusiones clave de Kurt

Aunque ChatGPT es una herramienta útil, está lejos de ser un sustituto de un ser humano, incluso con la introducción del Agenteque añade capacidades pero sigue careciendo de verdadera empatía, juicio y comprensión emocional. Las salvaguardias contribuyen en gran medida a abordar las preocupaciones sobre las implicaciones éticas y psicológicas de la IA. Es bueno que OpenAI sea consciente de esto, porque es sólo el principio. Para proteger realmente a los usuarios, la empresa tendrá que seguir evolucionando la forma en que ChatGPT gestiona las conversaciones emocionalmente delicadas.

¿Crees que se debería utilizar la IA para la salud mental? Háznoslo saber escribiéndonos a Cyberguy.com/Contacto

Suscríbete a mi Informe CyberGuy GRATUITO

Recibe mis mejores consejos tecnológicos, alertas de seguridad urgentes y ofertas exclusivas directamente en tu bandeja de entrada. Además, obtendrás acceso instantáneo a mi Guía Definitiva de Supervivencia a las Estafas - gratis al unirte a mi CYBERGUY.COM/NEWSLETTER

Copyright 2025 CyberGuy.com. Todos los derechos reservados.