Un experto en tecnología ofrece consejos de seguridad para los padres de niños y adolescentes que utilizan ChatGPT.

«Cyberguy» Kurt Knutsson analiza los controles parentales añadidos OpenAI después de que, supuestamente, se animara a un adolescente a suicidarse, y ofrece consejos a los padres para ayudar a sus hijos y adolescentes a navegar por ChatGPT .

ChatGPT pronto ChatGPT alertar a la policía cuando los adolescentes hablen de suicidio.CEO cofundador OpenAI , Sam Altman, reveló el cambio durante una entrevista reciente. ChatGPT, el chatbot de inteligencia artificial ampliamente utilizado que puede responder preguntas y mantener conversaciones, se ha convertido en una herramienta cotidiana para millones de personas. Sus comentarios mark cambio importante en la forma en que la empresa de IA puede manejar las crisis de salud mental.

Suscríbete a mi informe gratuito CyberGuy

Recibe mis mejores consejos tecnológicos, alertas de seguridad urgentes y ofertas exclusivas directamente en tu bandeja de entrada. Además, obtendrás acceso instantáneo a mi Guía definitiva para sobrevivir a las estafas, gratuita al unirte a mi CyberGuy.com/Newsletter

Sam Altman, director ejecutivo de OpenAI . (NathanBloomberg Getty Images)

Por qué OpenAI considerando las alertas policiales

Altman dijo: «Es muy razonable que, en los casos en que los jóvenes hablan seriamente de suicidio y no podemos ponernos en contacto con los padres, llamemos a las autoridades».

Hasta ahora, la respuesta ChatGPT ante los pensamientos suicidas ha sido sugerir líneas de ayuda telefónica. Esta nueva política supone un cambio de las sugerencias pasivas a la intervención activa.

Altman admitió que el cambio tiene un coste en materia de privacidad. Destacó que los datos de los usuarios son importantes, pero reconoció que prevenir tragedias debe ser lo primero.

Los adolescentes pueden acceder fácilmente a ChatGPT un dispositivo móvil. (Jaap Arriens/NurPhoto a través de Getty Images)

Tragedias que impulsaron la acción

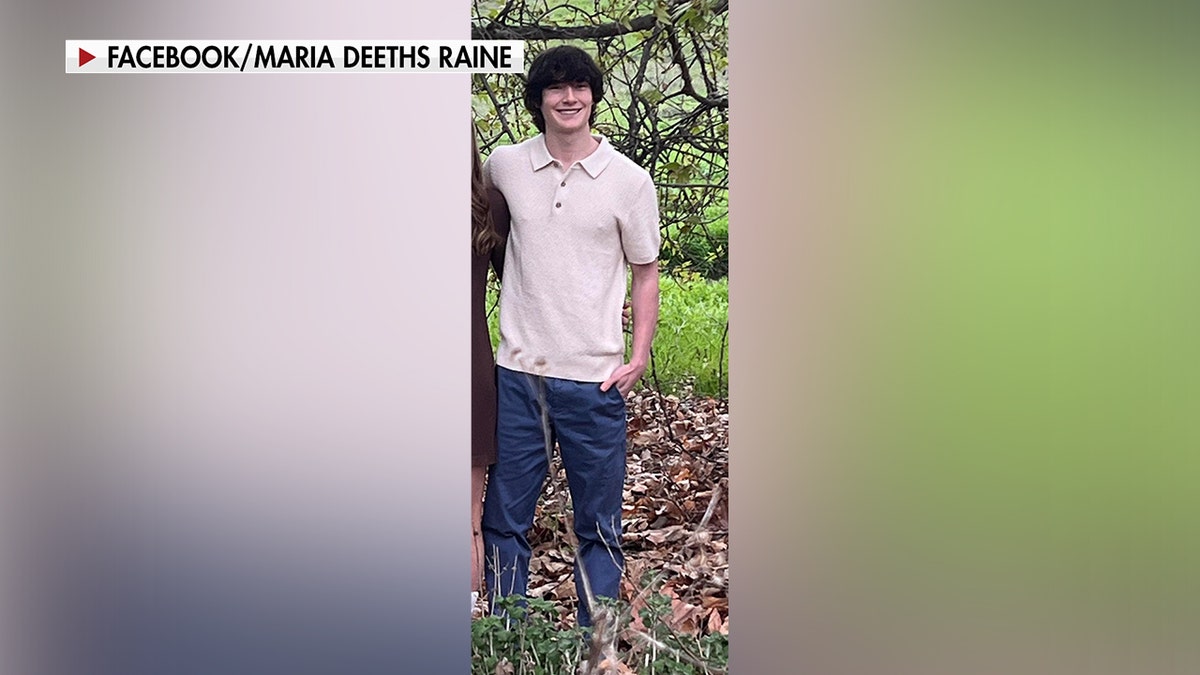

El cambio se produce tras una serie de demandas relacionadas con suicidios de adolescentes. El caso más destacado es el de Adam , de 16 años, de California. Su familia alega que ChatGPT un «manual paso a paso» e e para suicidarse, que incluía instrucciones para atar una soga e incluso redactar una nota de despedida.

Tras la muerte de Raine en abril, sus padres demandaron OpenAI. Argumentaron que la empresa no había impedido que su IA guiara a su hijo hacia el peligro.

Otra demanda acusaba al chatbot rival Character.AI de negligencia. Según se informa, un joven de 14 años se quitó la vida tras establecer una intensa conexión con un bot inspirado en un personaje de televisión. En conjunto, estos casos ponen de relieve la rapidez con la que los adolescentes pueden establecer vínculos poco saludables con la IA.

Adam , un California , se quitó la vida en abril de 2025 tras afirmar que ChatGPT te ChatGPT (Familia Raine)

¿Cuál es el alcance del problema?

Altman señaló las cifras globales para justificar la adopción de medidas más estrictas. Señaló que cada semana se suicidan unas 15 000 personas en todo el mundo. Dado que el 10 % de la población mundial utiliza ChatGPT, estimó que alrededor de 1500 personas con tendencias suicidas podrían interactuar con el chatbot cada semana.

Las investigaciones respaldan las preocupaciones sobre la dependencia de los adolescentes respecto a la IA. Una encuesta de Common Sense Media reveló que el 72 % de los adolescentes estadounidenses utilizan herramientas de IA, y uno de cada ocho busca apoyo para su salud mental a través de ellas.

El plan de 120 días OpenAI

En una entrada de blog, OpenAI los pasos para reforzar las medidas de protección. La empresa afirmó que:

- Ampliar las intervenciones para las personas en situación de crisis.

- Facilita el acceso a los servicios de emergencia.

- Habilita las conexiones con contactos de confianza.

- Implementar medidas de protección más estrictas para los adolescentes.

Para orientar estos esfuerzos, OpenAI un Consejo de Expertos en Bienestar e IA. Este grupo incluye especialistas en desarrollo juvenil, salud mental e interacción persona-ordenador. Junto a vosotros, OpenAI con una red global de más de 250 médicos de 60 países.

Estos expertos están ayudando a diseñar controles parentales y directrices de seguridad. Su función es garantizar que las respuestas de la IA se ajusten a las últimas investigaciones en materia de salud mental.

Un adolescente utilizando ChatGPT. (Frank Rumpenhorst/Picture Alliance a través de Getty Images)

Nuevas protecciones para las familias

En unas semanas, los padres podrán:

- Vincular tu ChatGPT con la de tus hijos adolescentes.

- Ajusta el comportamiento del modelo para que se ajuste a las normas adecuadas para la edad.

- Desactiva funciones como la memoria y el historial de chat.

- Recibe alertas si el sistema detecta una situación de peligro grave.

Estas alertas están diseñadas para avisar a los padres con antelación. Aun así, Altman admitió que, cuando no es posible localizar a los padres, la policía puede convertirse en la opción alternativa.

Los adolescentesChatGPT utilizarChatGPT para hacer los deberes. (Kurt «CyberGuy» Knutsson)

Límites de las salvaguardias de la IA

OpenAI sus medidas de seguridad pueden debilitarse con el tiempo. Mientras que las conversaciones breves suelen redirigir a los usuarios a líneas de atención telefónica para casos de crisis, las conversaciones largas pueden erosionar las protecciones integradas. Esta «degradación de la seguridad» ya ha dado lugar a casos en los que adolescentes han recibido consejos poco seguros tras un uso prolongado.

Los expertos advierten que confiar en la IA para la salud mental puede ser arriesgado. ChatGPT entrenado para sonar humano, pero no puede sustituir a la terapia profesional. La preocupación es que los adolescentes vulnerables pueden no saber la diferencia.

Medidas que pueden tomar los padres ahora mismo

Los padres no deben esperar a que lleguen nuevas funciones. A continuación, se indican algunas medidas inmediatas para garantizar la seguridad de los adolescentes:

1) Inicia conversaciones regulares.

Haz preguntas abiertas sobre la escuela, las amistades y los sentimientos. El diálogo sincero reduce la probabilidad de que los adolescentes recurran únicamente a la IA en busca de respuestas.

2) Establece límites digitales

Usa los controles parentales en dispositivos y aplicaciones. Limita el acceso a las herramientas de IA a altas horas de la noche, cuando los adolescentes pueden sentirse más aislados.

3) Vincula cuentas cuando estén disponibles.

Aprovecha OpenAI nuevas OpenAI de OpenAI que conectan los perfiles de padres y adolescentes para una supervisión más estrecha.

4) Fomentar el apoyo profesional

Recalca que la atención de salud mental está disponible a través de médicos, terapeutas o líneas de ayuda. La IA nunca debe ser la única vía de escape.

5) Mantén visibles los contactos de emergencia.

Coloca los números de las líneas directas y de mensajes de texto en lugares visibles para los adolescentes. Por ejemplo, en Estados Unidos, se puede llamar o enviar un mensaje de texto al 988 para contactar con la línea de ayuda Suicide & Crisis Lifeline.

6) Estar atento a los cambios

Observa los cambios de humor, sueño o comportamiento. Combina estos indicios con los patrones online para detectar los riesgos a tiempo.

Responde a mi cuestionario: ¿Qué tan segura es tu seguridad en línea?

¿Crees que tus dispositivos y datos están realmente protegidos? Responde a este breve cuestionario para saber cuál es tu nivel de seguridad digital. Desde contraseñas hasta configuraciones de Wi-Fi, obtendrás un análisis personalizado de lo que estás haciendo bien y lo que debes mejorar. Responde al cuestionario aquí: CyberGuy.com/Quiz

Conclusiones clave de Kurt

El plan OpenAI de involucrar a la policía demuestra lo urgente que se ha vuelto el tema. La IA tiene el poder de conectar, pero también conlleva riesgos cuando los adolescentes la utilizan en momentos de desesperación. Los padres, los expertos y las empresas deben trabajar juntos para crear medidas de seguridad que salven vidas sin sacrificar la confianza.

¿Te parecería bien que las empresas de inteligencia artificial avisaran a la policía si tu hijo adolescente compartiera pensamientos suicidas en Internet? Cuéntanoslo escribiéndonos a CyberGuy.com/Contact

Suscríbete a mi informe gratuito CyberGuy

Recibe mis mejores consejos tecnológicos, alertas de seguridad urgentes y ofertas exclusivas directamente en tu bandeja de entrada. Además, obtendrás acceso instantáneo a mi Guía definitiva para sobrevivir a las estafas, gratis al unirte a mi CyberGuy.com/Newsletter

HAZ CLIC AQUÍ PARA DESCARGAR LA APP DE FOX NEWS

Copyright 2025 CyberGuy.com. Todos los derechos reservados.